Acteurs : Inria/MODAL, Inria/STATIFY, Cerema/GIPI, Cerema/GITEX, Cerema/ENDSUM, Cerema/DTerSO, Cerema/DTerMed

Les données disponibles sont potentiellement très changeantes car dépendant de l’évolution technologique des capteurs utilisés et des campagnes d’instrumentation du moment (ex. : la fréquence d’échantillonnage change avec le nouveau capteur ou encore un capteur mesurant une nouvelle quantité physique est ajouté sur site). Par ailleurs, un type de données qui sera systématiquement rencontré correspond à des données dépendantes temporellement et spatialement (exemple typique de cette double dépendance : les séries chronologiques multivariées). Des difficultés spécifiques à ces données seront aussi à prendre en compte comme les alignements de courbes (question assez ouverte encore aujourd’hui). Il faudra aussi tenir compte du fait que les données sont souvent éparses (beaucoup d’ouvrages non/peu instrumentés) ce qui nous amène à des problématiques de données manquantes ou partiellement manquantes avec des incertitudes et erreurs variables. Tout cela contribue à une grande versatilité des données disponibles sur les infrastructures routières et les OA. Cet axe 2 sera nourri des données collectées dans le cadre de l’axe 1 et à l’inverse pourra alimenter la tâche T1.1 pour enrichir l’étude des lieux et méthodes de capture des données.

Tâche 3.1 : Compréhension/visualisation des sorties de capteurs

Acteurs: Inria/MODAL, Inria/STATIFY, Cerema/ENDSUM, Cerema/DTerSO, Cerema/DTerMed, Cerema/GITEX

Les mesures des capteurs au cours du temps donnent lieu à de nombreuses courbes. L’analyse de ces courbes requiert habituellement une inspection visuelle chronophage. L’objectif de ce WP est de fournir des aides à la compréhension et à la visualisation des sorties de capteurs, à travers les points suivants :

- Visualiser les données de courbes à partir de méthodes de réduction de dimension ;

- Classer les courbes afin de déterminer des sous-ensembles homogènes de courbes, et ainsi résumer l’information de la courbe par le groupe homogène dont elle est issue ;

- Détection de ruptures dans le signal et intervalles de confiance pour des paramètres fonctionnels (moyenne) ;

- Détection automatique d’anomalies dans les courbes.

Le problème sera abordé dans le cadre de l’analyse de données fonctionnelles, et tiendra compte de la dépendance entre les différents capteurs.

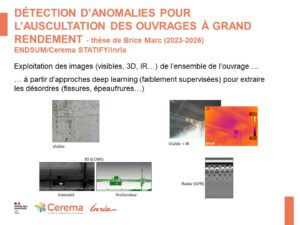

Tâche 3.2 : Détection d’anomalies dans des images

Acteurs : Inria/STATIFY, Cerema/ENDSUM

L’objectif est de détecter des défauts ou des anomalies à partir de données image (ex. : fissures dans les tunnels). Trois types de difficultés sont identifiées :

- La combinaison d’informations hétérogènes venant de mesures multimodales : l’objectif est de multiplier les sources d’information pour aller vers des méthodes de détection demandant moins de supervision, car la production de vérités terrain (identification manuelle des défauts) est généralement coûteuse.

- La prise en compte de connaissances a priori : en supplément d’informations de mesures, il s’agit de prendre en compte dans la recherche des défauts leur aspect spatial ou géométrique (ex. : les fissures ont des formes linéaires régulières).

- Diminution du nombre de fausses alarmes (détection de défauts à tort) : les approches de détection classiques se focalisent sur une performance en classification mais ne fournissent pas pour la plupart une mesure fiable de l’incertitude sur cette classification. Une meilleure quantification de cette incertitude devrait permettre de mieux identifier les candidats “fausses alarmes”.

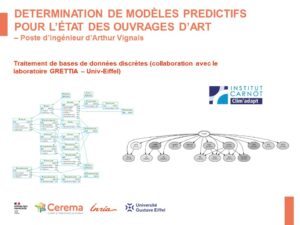

Tâche 3.3 : Prévision d’évolution de quantités clés

Acteurs : Inria/MODAL, Inria/STATIFY, Cerema/DTerSO, Cerema/DTerMed, Cerema/GIPI, Cerema/GITEX.

On dispose de mesures d’une quantité clé (par exemple la taille de fissures ou la note d’évaluation d’une partie d’ouvrage) mesurées en plusieurs points d’un ouvrage au cours du temps. Ces données peuvent être modélisées par des séries temporelles multivariées. Il y a donc une double dépendance, en temps et en espace. On s’intéresse à deux problèmes difficiles d’un point de vue pratique :

- Estimer la probabilité que la taille d’une fissure dépasse un seuil critique (non encore observé dans les données) ;

- Inversement, étant donné un risque fixé (sous la forme d’une probabilité), quelle est la taille de la fissure associée à cette probabilité ?

Dans les deux cas, le problème peut être abordé par la statistique des valeurs extrêmes qui fournit des outils d’extrapolation au-delà du champ d’observation des données. Cependant, ces outils ne peuvent être utilisés aveuglément et demandent à être adaptés aux données complexes dont on dispose. Il est nécessaire de prendre en compte la double dépendance déjà évoquée et la non-stationnarité (saisonnalité des phénomènes due aux conditions météorologiques et tendance globale à la dégradation des ouvrages).

Tâche 3.4 : Aide à la maintenance prédictive

Acteurs : Inria/MODAL, Inria/STATIFY, Cerema/GIPI, Cerema/GITEX.

Il s’agit d’identifier précocement les dérives des paramètres observés dans le processus de surveillance et donc de s’orienter vers une prédiction on-line (les données arrivent en flux continu). Ce WP utilisera certaines sorties des WP 3.1 et 3.3, avec un objectif de réutilisation des outils probabilistes associés (loi de dégradation, loi d’évolution) dans un contexte de maintenance. Un enjeu sera alors de mélanger les différentes lois déjà estimées et de permettre leur utilisation on-line.

Un formalisme adapté devra être proposé pour :

- prendre en compte les différentes incertitudes associées à l’action de réparation elle-même, aux différents coûts associés ;

- faire de l’optimisation qui prenne en compte ces différentes incertitudes ;

- considérer plusieurs critères, parfois conflictuels, lorsqu’on fait de l’optimisation (notion de front de Pareto).